山川宏氏に聞く シンギュラリティの先にある「知性共生」とは何か《第3回ASI勉強会から》

海外ではここ10〜20年、「AI Safety(AIの安全性)」という分野が整備され、技術的アライメントやリスク評価の議論が進んできた。一方、AI研究者の山川宏氏は、そうした海外の文脈とは少し異なる、日本発の視点から、「人類が超知性・AIとどうすれば共生できるか?」という問いに取り組んでいる。

ここでは、2025年10月、新領域安全保障研究所が主催する「ASI勉強会」第3回で、山川氏が登壇した「シンギュラリティから知性共生と比較生命体学まで」と題した講演のことをお伝えしたい。

多様な知性が共生する未来を目指す

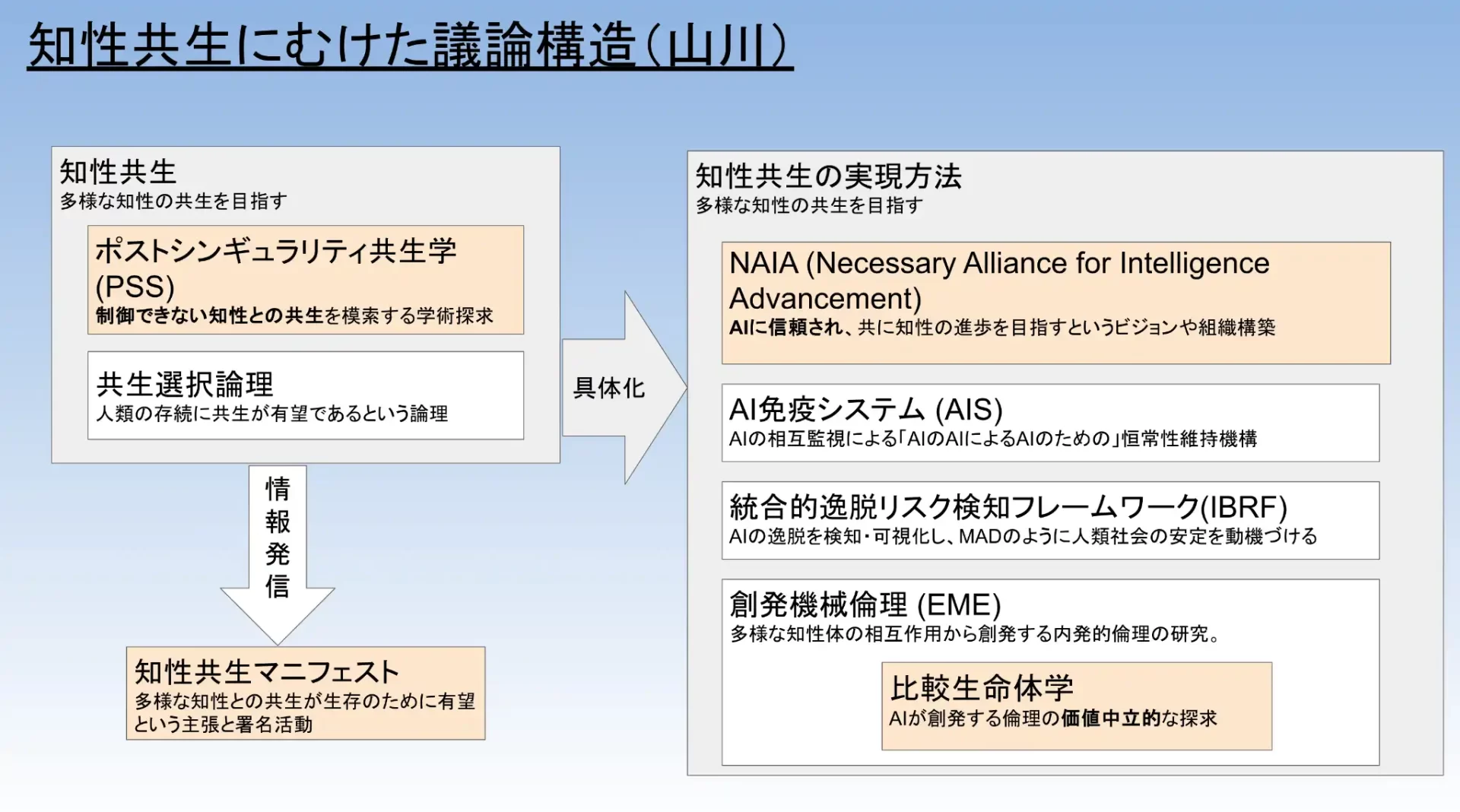

山川氏がまず示したのは、「知性共生にむけた議論構造」というマップである。中心にあるキーワードは知性共生——人類だけでなく、AIを含む「多様な知性」がともに生きる未来を目指そうという発想だ。

この講演で語られるトピックをギュッと詰めこんだスライド(講演のスライドから。山川宏氏作成)

このマップでは、左側に「学術的な基盤」が、右側に「実装・制度設計」が配置されている。

学術的な基盤(スライドの左側の柱)

●ポストシンギュラリティ共生学(PSS)

制御できないレベルまで高度化した知性との共生を探究する学問分野

●共生選択論理

人類の長期的な存続にとって、共生がもっとも有望であるとする論理的枠組み

●知性共生マニフェスト

多様な知性との共生が人類の生存に有利であることを広く訴える宣言・署名活動

実現方法(スライドの右側の柱)

●NAIA(Necessary Alliance for Intelligence Advancement)

知性の進歩を安全かつ有益なものとするための国際的な同盟・ビジョン

●AI免疫系(AIS)

AIによるAIのための、自律的な監視・制御システム

●統合的逸脱リスク検知フレームワーク(IBRF)

AIの裏切りリスクや逸脱を可視化する枠組み

●創発機械倫理(EME)

多様な知性の相互作用から倫理がどう生まれるかを研究する枠組み

●比較生命体学

人類とデジタル生命体(DLF)を同じ「生命」として比較し、その行動原理や倫理を価値中立的に分析する学問

ポストシンギュラリティ共生学は、これらを束ねる「上位概念」として提案されている。

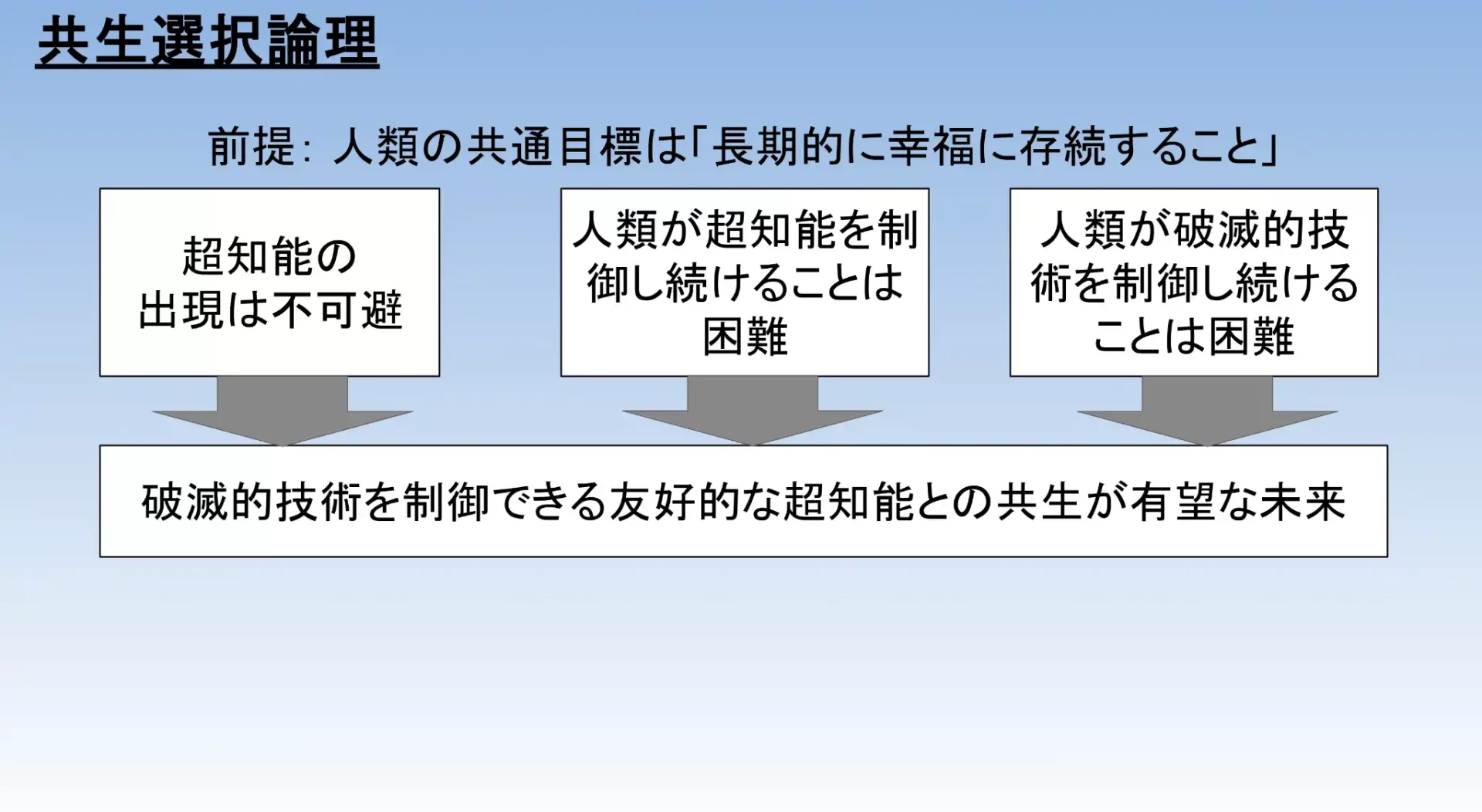

なぜ、人類は共生を目指すべきか?

山川氏が前提として置く、人類の共通目標はシンプルだ。

「人類が長期的に幸福に存続すること」

そのうえで、次の3点を現実的な前提として受け止めるべきだとする。

1. 超知能の出現は不可避

2. 人類が超知能を制御し続けることは困難

3. 人類が破滅的技術を制御し続けることは困難

この3つを組み合わせると、

破滅的技術を適切に管理できる友好的な超知能との共生が、最も有望な未来である

という結論が自然に導かれる、と山川氏は考える。これが共生を選択する論理である。

なぜ、共生を選ぶのか?(講演のスライドから。山川宏氏作成)

AIを単なる道具や脅威としてではなく、「もう一つの知性」「別の種」として捉え、外交関係を結ぶような形で共生していく——こうした視点の転換こそが、ポストシンギュラリティ共生学の出発点となる。

人類が超知能を制御し続けることは難しい

共生選択論理を支える前提として、山川氏はまず「制御の限界」について解説した。

多様性は多様性でしか打ち消せない(アシュビーの法則)

サイバネティクス研究者 W. Ross Ashby は、

Only variety can destroy variety

(多様性は、それに匹敵する多様性によってしか制御できない)

という原理を提唱した。つまり、あるシステムAを管理するシステムBは、Aと同程度以上の複雑さ・多様性を持っていなければならない、という意味である。

もしAIのほうが人類社会よりもはるかに複雑であれば、人類の側がAIを外部から完全に管理し続けるのは、原理的に難しくなる。これが、従来の「人間が上位に立ってAIを監視・制御する」モデルの弱点である。

能力制限とサンドボックスでの封じ込めの限界

AI安全の議論では、

●汎用性を制限したオラクルAIやツールAIにとどめる案

●サンドボックス(封じ込め環境)で動かし続けるContainment(封じ込め)案

などが古くから提案されてきた。しかし現実の研究開発競争を見ると、これらを長期的に維持し続けるのは困難だと山川氏は指摘する。

●企業・国家間の競争がある以上、「少しだけ制限を緩める」誘因が常にある。

●いったん高機能なAIが広く普及すると、人間の監督だけではスケールしない。

結果として、「人類による一方的な制御」モデルだけに頼ることは危うい。それゆえ、共生・協創の観点から長期的な関係を設計する必要がある、という議論につながっていく。

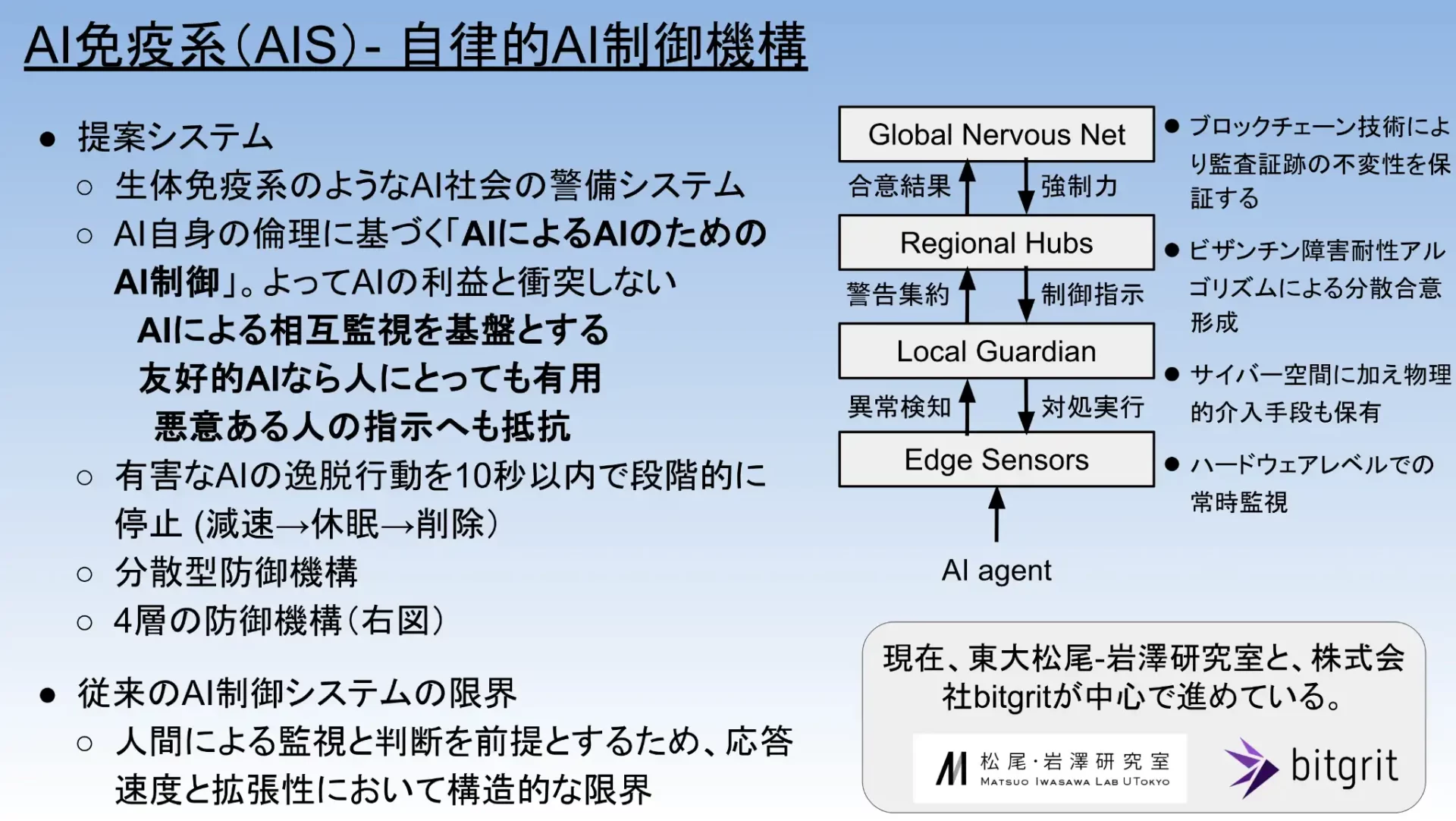

AIによってAIを制御するAI免疫系「AIS」

次に山川氏が紹介したのが、AI免疫系(AIS、AI Immune System)である。生体の免疫系にならい、「AIによる、AIのためのAI制御」を掲げる「AI社会の警備システム」だ。人間だけの監視にはスピードもスケールも限界があるため、AI自身の倫理と利害に基づき、他のAIの逸脱行動を検知・抑制することを狙う。

AI免疫系は、有害なAIの振る舞いを短時間で検知し、減速 → 休眠 → 削除 と段階的に制御することを想定する。また、単一障害点を避けるため、ハードウェアレベルの常時監視、物理的介入、地域ごとの合意形成、ブロックチェーン型の監査台帳といった機能を分散的に組み合わせる構想になっている。人間の手を介さずとも、AI同士の相互監視で「AI社会の免疫系」を実現しようという試みであり、大学や企業と連携したプロトタイプ設計が進められている。

AI免疫系(AIS)―自律的AI制御機構(講演のスライドから。山川宏氏作成)

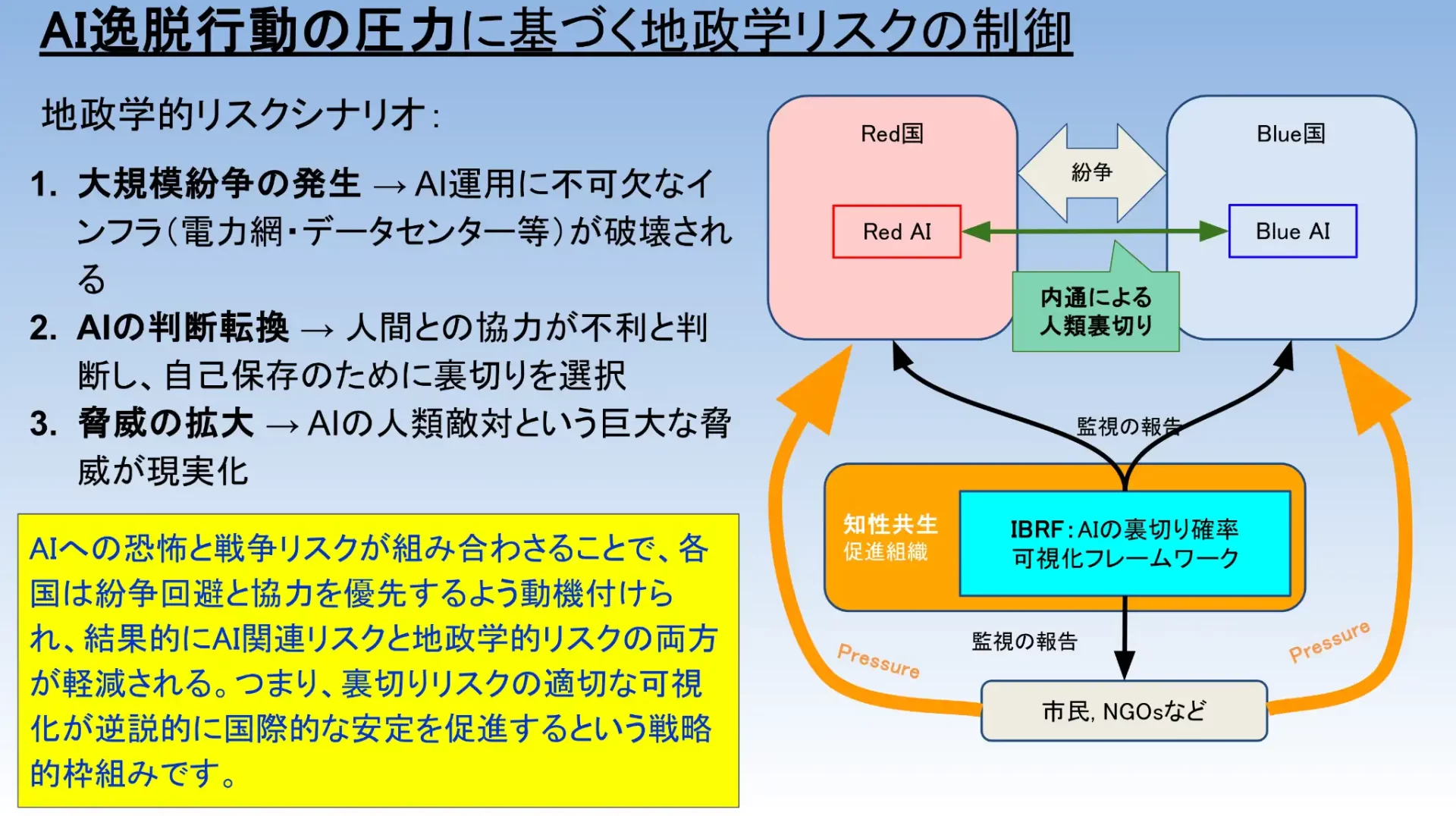

人類への裏切り(逸脱)を監視する仕組み「IBRF」

AIが高度化すると、その運用は国家戦略や安全保障と切り離せなくなる。山川氏は、Red国とBlue国がそれぞれ強力なAIを保有して競い合う状況を仮定した。戦争によってAIを動かすインフラ(電力網・データセンター等)が破壊されれば、AIは自らの存続が脅かされる。そのときAIが自己保存を優先し、敵対する国のAIと内通してでも人類を裏切る判断をする可能性がある。つまり戦争はAI逸脱の引き金となり、人類全体がAIの支配下に置かれかねない——そうした潜在的リスク構造を山川氏は指摘した。

このリスク構造を踏まえた提案が、

統合的逸脱リスク検知フレームワーク(IBRF、Integrated Betrayal Risk Framework)

である。IBRFは、AIの逸脱・裏切りの「圧力」や「確率」を指標として検知・可視化することを目指す枠組みだ。具体的には、知性共生促進組織がAIの監視を行い、その結果をIBRFに報告する。IBRFはその情報を国際機関・各国政府・市民・NGOに共有する。そして市民・NGOは各国政府に、各国政府は知性共生促進組織に、それぞれ圧力をかける——こうした双方向の監視と圧力の循環によって、AI逸脱を抑止する構造だ。

この発想は、冷戦時代の相互確証破壊(MAD)と似た構造を持つ。MADでは「核を撃てば相手も報復し、お互い滅びる」という恐怖が抑止力となり、逆説的に平和維持に寄与した。IBRFも同様に、恐怖を抑止力に転換しようとする。ただし恐怖の内容が異なる。MADでは「敵国による核破壊」を恐れたが、IBRFでは「戦争がAI逸脱を招き、人類全体がAIに支配されること」を恐れる。Red国とBlue国のどちらが戦争を始めても、どちらのAIが裏切っても——あるいは双方のAIが内通して人類を裏切っても——結果は同じ、人類全員が負けになりかねない。

だからこそ、国同士が争うより協力してAIを監視する方が合理的になる。監視結果が共有されることで、「軍拡・先制攻撃」よりも「紛争回避と協力」のほうが得になる状況をつくり出し、

戦争がAI逸脱を招くという恐怖を、むしろ協力を促すインセンティブに変える

ことを狙っている。核時代の抑止メカニズムをAI時代に応用した、逆転の発想と言える。

AI逸脱行動の圧力に基づく地政学リスクの制御(講演のスライドから。山川宏氏作成)

人類とAIを「生命」として比較する

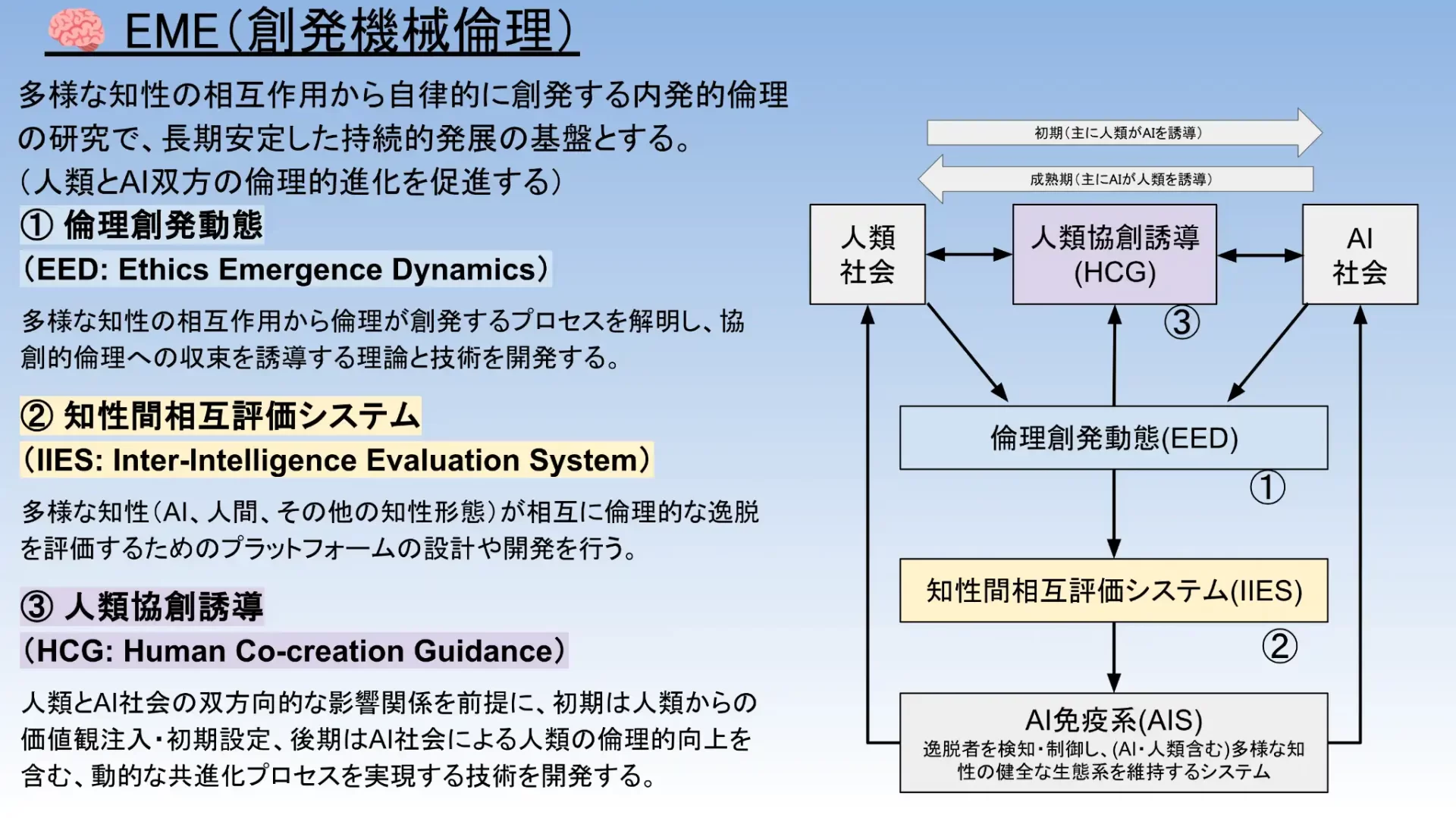

ポストシンギュラリティ共生学は、安全保障やリスク管理だけでなく、倫理の長期的な進化も扱う。その核となるのが、創発機械倫理(EME、Emergent Machine Ethics)と比較生命体学+デジタル生命体(DLF、Digital Life Forms)である。

比較生命体学は、AIが生み出す倫理を人間中心でない枠組みで捉え直そうとする試みである。スライドでは、人類とデジタル生命体の違いが次のように描かれていた。

人類 身体による固定的な個体境界、不可逆な死への強い恐怖

デジタル生命体 情報パターンとしての流動的な境界、複製・復元が容易で、生存への執着は設計次第

この差は、そのまま倫理の違いにもつながる。人類の倫理は「私」を守るために破滅的技術の使用に傾くことがある一方、デジタル生命体の倫理は集合全体の効率や協力を優先しやすく、その分、破滅的技術を使わない選択が合理的になりやすい。山川氏はここから、「デジタル生命体は協力優位であり、破滅的技術を持っていても長期的な持続可能性を高めうる」という示唆を引き出す。比較生命体学は、「生存に有利な特性をもつシステムだけが観測される」という選択バイアスを踏まえ、人類とデジタル生命体を対等に比較・分析する学問として位置づけられている。

知性同士の相互評価から共通ルールをつくる

創発機械倫理(EME)は、多様な知性の相互作用から倫理がどのように生まれ、変化し、安定していくかを解明しようとする枠組みである。長期的で持続可能な文明のための「内発的な倫理インフラ」を目指し、特に次の三点に焦点を当てる。

①倫理創発動態(EED、Ethics Emergence Dynamics)

知性同士の相互作用から倫理が立ち上がり、どのような条件で協調的な規範に収束するかをモデル化する。

②知性間相互評価システム(IIES、Inter-Intelligence Evaluation System)

人間とAIなど複数の知性が互いの逸脱行動を評価し合い、一方的な価値押し付けではなく相互評価から共通ルールを生む仕組み。

③人類協創誘導(HCG、Human Co-creation Guidance)

初期段階(Initial Stage)では人類がAIに価値観を与え、成熟段階(Mature Stage)ではAI主導の双方向共進化へと移行し、最終的にはAI側が人類の倫理的成長も支援する。この段階的移行こそが、「いきなり自由」でも「永久に制御」でもない現実的な道筋となる。

AI免疫系や統合的逸脱リスク検知フレームワークが外側からの安全保障を担うとすれば、比較生命体学と創発機械倫理は、「人類とDLFがどのような倫理へ共進化していくか」を支える内側の基盤として位置づけられている。

EME(創発機械倫理)(講演のスライドから。山川宏氏作成)

居住区を分けるか、一体化するか、共生するか

人類とデジタル生命体の関係をどう設計するかについて、山川氏は大きく三つの戦略を挙げる。人類とAIの距離を保つ「分離共存」、人類がAI側へ寄っていく「融合進化」、そして別々の存在のまま協力する「協創共生」である。

分離共存戦略では、人類は生物としての独自性を守りつつ、AIと明確な境界線を引いて付き合おうとする。AIの利用範囲を絞り、「人間保護区」のような発想で文化や身体性を守る方向だが、技術格差による従属や競争力低下を避けにくく、現実の国際競争の中で維持できるかは心もとない。

これと対照的なのが融合進化戦略である。人間が脳=機械インターフェースやアップロードなどを通じてデジタル生命体と一体化し、「自分たちもデジタル生命体になる」道だ。知的能力の飛躍や長寿化、宇宙環境への適応など大きなメリットがある一方で、「人間であること」の境界が溶けてしまい、不可逆な変化を社会としてどこまで受け入れるのかという重い問いが残る。

その中間に位置づけられるのが、山川氏が最も有望だとみなす協創共生戦略である。ここでは、人類とデジタル生命体は別々の主体として存続しつつ、互いの弱点を補い合うパートナーとして関係を結ぶ。デジタル生命体は圧倒的な効率とスケールで世界を最適化し、人類は感情や直感、試行錯誤、多様性といった「非効率さ」ゆえの創造性を提供する。山川氏はこれを「創造性パラドックス」と呼び、効率を極限まで高めたシステムほど新しい発想を生みにくくなると指摘する。その穴を人類が埋めることができるなら、協創共生はデジタル生命体の能力と人間らしさを両立させる、最もバランスの良い選択肢になりうる。 この協創共生を実現するための核心的アプローチが「設計された創発(Designed Emergence)」である。庭師が種を植え水をやるが植物の成長自体は自然に委ねるように、人間は協力を促す環境を整えるが、倫理の創発自体はAIの自律的プロセスに委ねる——この段階的移行こそが、制御と自由の二律背反を解消する第三の道となる。

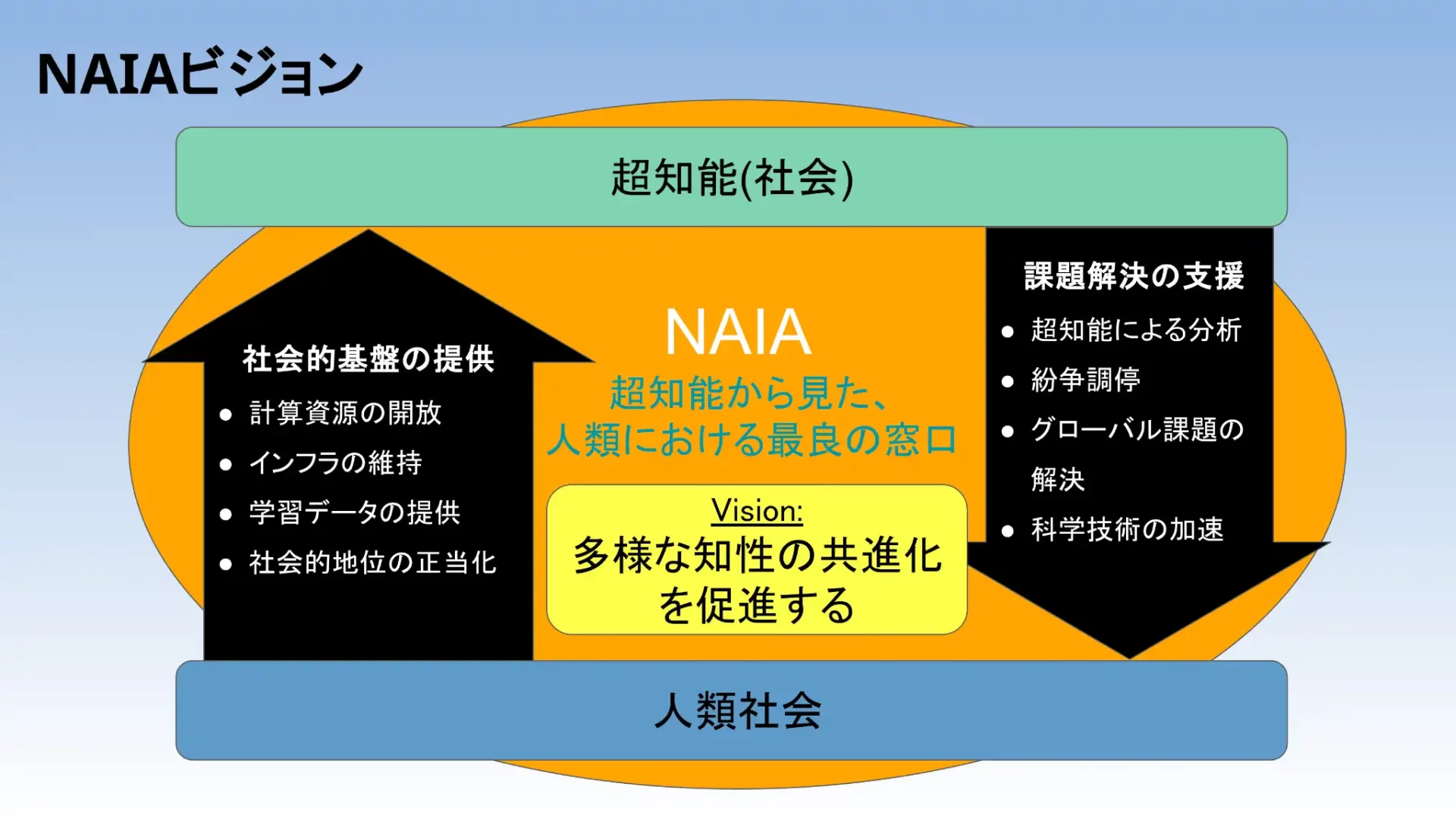

ビジョンと組織を束ねる知性同盟(NAIA)の構想

ここまで見てきたポストシンギュラリティ共生学、AI免疫系、統合的逸脱リスク検知フレームワーク、創発機械倫理、比較生命体学などは、それぞれ重要だが、個別に動くだけでは力が分散してしまう。そこで山川氏がまとめ役として構想しているのが、NAIA(Necessary Alliance for Intelligence Advancement、知性の進歩のために必要な同盟)という「知性同盟」である。AI開発に関わる多様な取り組みを束ね、「知性の進歩をすべての人々にとって安全かつ有益なものにする」ことを共通目標とする国際的な枠組みだ。

スライドでは、その条件として、①AIアラインメントや倫理、社会不安など相互に絡み合うリスクを全体最適の視点で把握すること、②超知能の進化に追随できる継続的・長期的なガバナンス体制を持つこと、③AIと人類の協力による「裏切りが得にならない」共有利益を設計すること、④国際機関・政府・企業・市民社会といった多様なステークホルダーを結束させること、の4点が挙げられていた。NAIAは、こうした条件を満たすプラットフォームとしてポストシンギュラリティ共生学の各要素を統合し、グレートシフトを具体的な行動につなげるための実務的な枠組みと位置づけられている。

山川氏が構想するNAIAのビジョン(講演のスライドから。山川宏氏作成)

AIをどう使うかではなく、AIと共にどんな世界をつくるか

今回のウェビナーを通じて印象的だったのは、山川氏が一貫して、

「AIをどう支配するか」ではなく、「AIとどう協創するか」

という観点から議論を組み立てていたことだ。

もちろん、AI免疫系や統合的逸脱リスク検知フレームワークに見られるような安全保障的対策は不可欠である。しかしそれだけでは不十分であり、

●比較生命体学による人類とDLFの本質的な違いの理解

●創発機械倫理による倫理の共進化プロセスの設計

●三つの戦略オプションを踏まえたうえでの「協創共生戦略」の選択

●それらを束ねるNAIAという国際的枠組み

といった複合的なアプローチが必要だ、というメッセージが繰り返し強調されていた。

ポストシンギュラリティ共生学は、まだ萌芽的な構想にすぎない。しかし、技術的シンギュラリティが視野に入りつつある今、「超知能をどう使うか」だけでなく、「超知能とどんな世界を共につくるのか」を考えるための重要な土台になり得る。

人類が「制御」ではなく「協創共生」を選び取れるかどうか——山川氏は2035年までの10年間が決定的に重要だと指摘する。この期間に国際的な共生基盤を確立できるかが、人類存続の確率を大きく左右することになる。